ADAS & objectdetectie via camerasystemen: de razendsnelle ontwikkeling

Ongeveer gelijktijdig met de introductie van de eerste Tesla Model S, verscheen er nog een nieuwe naam in de autobranche: Mobileye. Waar de focus bij veel andere ontwikkelaars van sensoren voor objectdetectie vooral lag bij een groot aantallen en enorme hoeveelheden vooraf ingeladen data (3D-kaarten van de omgeving), richtte Mobileye zich vooral op één camerasysteem (het mobiele oog) dat real time situaties volledig zelf kan inschatten. We behandelen in dit artikel de verschillende versies van autonoom rijden die dit mogelijk maakt en hoe deze ontwikkeling zich zal voortzetten.

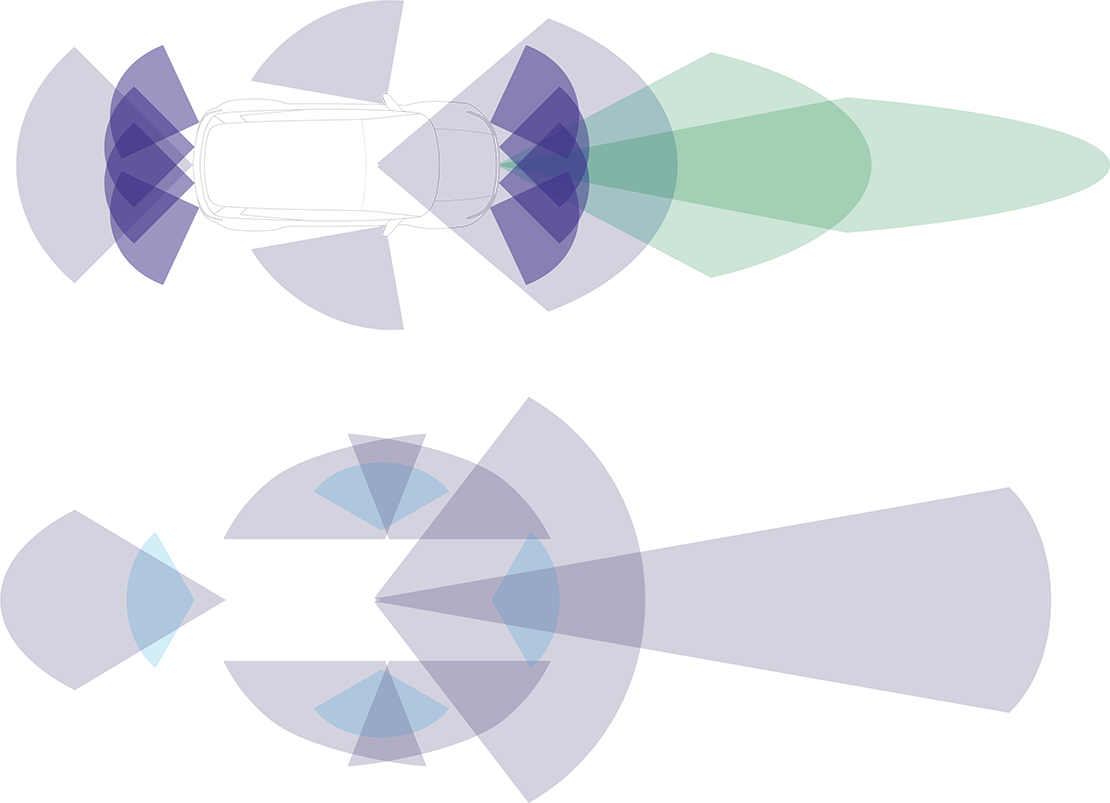

Schematische afbeelding werking ADAS traditioneel (boven) vs werking ADAS volgens Mobileye (onder)

Mobileye EyeQ: autonomie-level 2+

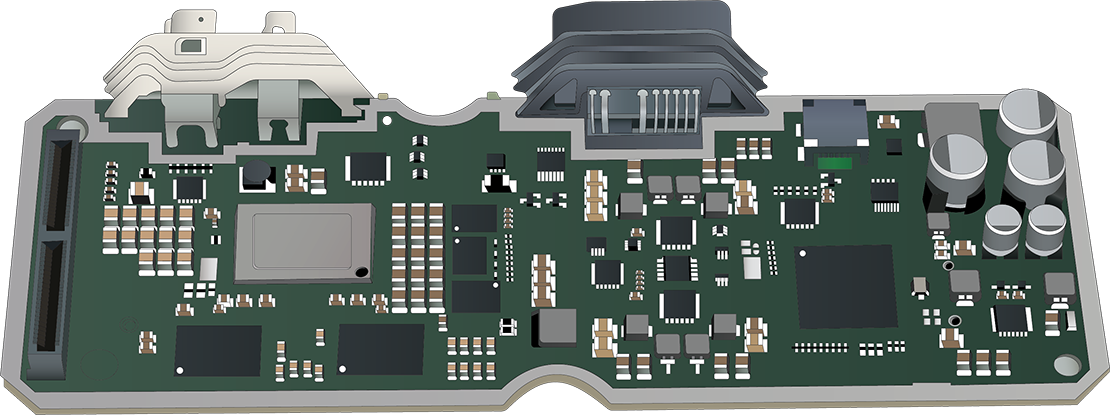

Aan de basis van de camera-only technologie van Mobileye staat de EyeQ: een speciaal ontwikkelde SoC (System on Chip). De EyeQ bleek direct bij de introductie in 2007 al de aandacht te trekken van meerdere grote autofabrikanten, die op zoek waren naar een partner die een compleet ADAS-systeem kon leveren. Inmiddels zijn er wereldwijd meer dan 100 miljoen (!) EyeQ’s verkocht, verdeeld over meer dan 700 automodellen van meer dan 35 verschillende autofabrikanten. Het nieuwste topmodel anno 2023, de EyeQ6H, beschikt intern over een eigen image signal processor (ISP), een grafische processor (GPU) én een video encoder. Hiermee is het mogelijk om systemen met autonomie-level 2+ aan te sturen. Ook de meest premium vormen van ADAS zijn voor deze SoC geen probleem. Met de hardware van dit kaliber, komt het waarschijnlijk niet als een verrassing dat deze techniek veel functionaliteit heeft. Functies zoals lane departure warning, lane keeping assist, automatic emergency braking, front collision warning, adaptive cruise control, traffic sign recognition, high beam assist en park assist zijn allemaal mogelijk met de EyeQ SoC. In bepaalde gevallen krijgt de centrale camera wel nog assistentie van radar.

Een kijkje binnenin de EyeQ

Mobileye REM: autonomie-level 3

Om autonomie-level 3 of hoger te kunnen bereiken zonder veel sensoren of grootschalige 3D-kaarten te gebruiken, ging Mobileye op zoek naar een alternatieve manier van voorkennis, waarmee EyeQ toch over meer informatie zou beschikken dan wat de camera op dat moment in beeld had.

De oplossing kwam in 2018 in de vorm van Road Experience Management (REM). In basis is dit een systeem waarbij iedere auto met zo’n nieuwe EyeQ SoC continu informatie opslaat van de wereld die de camera ziet. Al deze informatie wordt centraal verzameld en omgezet in een Roadbook: een eigen realtime kaart waarbij niet alleen de omgeving bekend is, maar ook duidelijk wordt op welke manier en met welke positionering gebruik gemaakt wordt van het wegvak. Al deze informatie wordt vervolgens weer Over-The-Air (OTA) gedeeld met de andere EyeQ-voertuigen, die daarmee betere beslissingen kunnen nemen in autonome modus.

Je kunt je misschien wel voorstellen dat, gezien de enorme aantallen EyeQ-SoC’s die er in omloop zijn, dit al vrij snel leidt tot een volledig en praktisch geheel. Zeker omdat dit systeem dus ook in zekere mate het lokale rijgedrag kan inschatten en daarop het autonome rijgedrag kan aanpassen. Snel invoegen is middenin een drukke stad bijvoorbeeld van veel groter belang dan ergens op het platteland.

Mobileye SuperVision ADAS

Hoe meer ADAS om zich heen kan kijken, hoe beter zo’n systeem werkt en hoe meer functionaliteiten mogelijk zijn. In samenwerking met autofabrikant Geely werd daarom SuperVision geïntroduceerd: een zeer uitgebreide vorm van ADAS met maar liefst 7 omgevingscamera’s, 4 parkeercamera’s en 2 SoC’s.

Door deze enorme upgrade is het SuperVision ADAS in staat om veel meer te reageren zoals een fysieke bestuurder dat ook zou doen. Staat er iemand bijvoorbeeld geparkeerd langs de weg met het portier open, dan houdt het systeem net iets meer (zijdelingse) afstand. En loopt er een voetganger vlak langs het wegvak, dan mindert het voertuig zijn snelheid. Het systeem is ook in staat om veel beter te anticiperen op verkeerssituaties zoals invoegen en plotseling van richting veranderende objecten. Al met al een mooie ontwikkeling dus.

Radar en LiDAR als back-up

Om voertuigen volledig autonoom (level 5) te kunnen laten rijden, dient er enorm veel zekerheid ingebouwd te worden in de systemen. En als je dan, net als Mobileye, alleen vertrouwt op camera’s, dan kom je al vrij snel in de knel. Niet omdat autonoom rijden op alleen camera’s niet mogelijk is, maar puur omdat er geen back-up is om te checken of de camera’s wel het juiste zien en het systeem daarmee de juiste inschatting maakt. Daarom heeft men toch de keuze gemaakt om zowel radar als LiDAR in te zetten. De benadering is alleen heel anders, zoals de hierna volgende tabel ook laat zien. Mobileye ziet radar en LiDAR namelijk niet als toevoeging om de informatie compleet te maken, maar vertrouwt het eigen camerasysteem genoeg om radar en LiDAR puur te zien als controlemiddel. Ze noemen dit zelf ‘true redundancy’.

Ook Nvidia houdt zich bezig met autonoom rijden

Waar Mobileye zich vooral richt op een universeel toepasbaar systeem, dat relatief eenvoudig overal in geïmplementeerd kan worden, heeft techgigant Nvidia altijd anders aangekeken tegen de problematiek rondom autonoom rijden en de daarbij horende gigantische hoeveelheid data. Omdat Nvidia zijn wortels heeft in de (grafische) computerindustrie, zien ze objectdetectie niet als een apart systeem, maar meer als onderdeel van het grotere geheel: de gehele auto. Eigenlijk een beetje zoals een grafische kaart een onderdeel is binnen een complete PC.

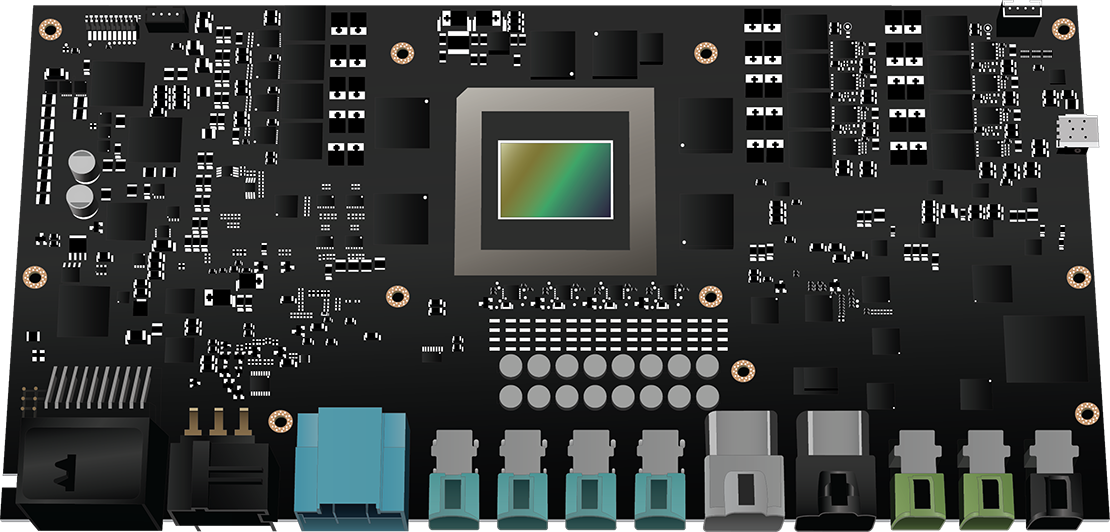

De Nvidia DRIVE Thor in detail

In september 2022 kondigde Nvidia daarom de “DRIVE Thor” aan, een allesomvattende centrale computer die ook systemen zoals autonoom rijden en parkeren, occupant monitoring, infotainment en het digitale instrumentenpaneel aanstuurt. Vooral de enorme rekenkracht (2000 teraflops) is Thor’s sterke punt en maakt meerdere losse control units compleet overbodig. Het platform laat bovendien multi-domain computing toe, waarmee autonoom rijden bijvoorbeeld volledig onafhankelijk en dus veilig kan functioneren naast de andere functies binnen deze supercomputer.

Hoe objectdetectie het motormanagement gaat beïnvloeden

Het is je waarschijnlijk wel duidelijk geworden dat al deze systemen de keuzes van de ECU enorm kunnen beïnvloeden. De boodschap die we met deze informatie willen overbrengen, is dat diagnose stellen door deze nieuwe technologie nooit meer hetzelfde zal zijn: Het gaspedaal is niet langer de enige input waarop het motormanagement dient te reageren. Het vinden van de oorzaak van een storing wordt daarmee een complex verhaal: Is de ECU wel echt defect? Of ontvangt deze gewoon niet de juiste input? En zit de oorzaak dus elders in de auto?

da

da de

de en

en es

es fr

fr it

it nb

nb pt

pt sv

sv fi

fi